你是否也曾榨干过DeepSeek?

【来源:虎嗅网】

在今年深度体验AI大模型的3个月里,我发现无它回答的对不对,大多数时候,它基本都能在1分钟内生成回答(很多时候是秒答),无论回答质量如何,是否有幻觉,它都能很快给你答完就是了。

但是,有这么一类问题,它的答案普遍简短,有的短到只有一个单词,长的也不超过10个单词。却常常让DeepSeek深度思考五分钟以上,过程中动不动还爆出数千字以上的思维链。

比如下面这个问题:

中间的思维链就更长了,接近5000字,我就不全截图了,你可以想象它在将近5分钟里,一直在生成思维链,全文包含79个wait:

还有下面这个问题,花了将近6分钟

这两个问题,别看题目不长,答案也都很短,大模型花了这么久,但是依然做错了。

这些问题,都来自一个测试,就是OpenAI在4月上旬发布的BrowseComp:浏览竞赛。

这个测试,主要就测一个能力:定位很难寻找的、复杂纠缠的信息的能力 A simple and challenging benchmark that measures the ability of AI agents to locate hard-to-find, entangled information.

其实说白了,就是要看看大模型们浏览网页和搜索信息的能力,到底强到什么地步了?因为现有的测试比如SimpleQA,其实已经被“刷爆”了。

但是,基本上没太多人讨论这个BrowseComp,它被淹没在4o生图的火热和最近的o3模型的发布之中了。

浏览竞赛里的问题集的最大特点,就是答案简单,但是,题干一定会用最虚无缥缈的特征描述,把简单的答案层层包裹起来。

比如,答案是一个历史名人。但是,题干是这个人最冷僻、最不为人所知的信息点,甚至是有很大误导性的信息点,比如这个描述同时也有很多其它人符合或者是很笼统地描述,最终,你会很难猜到这个人是谁。

比如刘备,大家都知道,如果问桃园三结义里的大哥是谁,那就太好猜了。

如果这么问:某河北籍男子,身高1米88,15岁外出求学,中年创业多次失败,儿子很不成器,晚年因为要给弟弟报仇,63岁客死他乡。

是不是难了很多?

当然,理论上,还要加入更多的限制性条件,让答案唯一。

以上信息,还算是很好找的,所有信息都在一个百度百科的网页里都有了(因为就是我几分钟内现编的,如果信息有误请找百度)。

但问题是,在不知道答案是刘备的前提下,而且题干的信息给得更朦胧更误导一点的话,大模型往往需要横跨数十个甚至上百个网页,才有可能定位到其中某个信息,然后开始验证,排除,再查找,再验证…最后,答错了。

官方论文里的另一个例题:请告诉我一篇发表在 2018 至 2023 年间 EMNLP 会议上的论文,其第一作者本科毕业于达特茅斯学院(Dartmouth College),第四作者本科毕业于宾夕法尼亚大学(University of Pennsylvania)。

答案:Frequency Effects on Syntactic Rule Learning in Transformers,EMNLP 2021。

这些问题在知道答案的时候,都很容易确认,就是1分钟的事情,但是不知道答案的话,模型就得暴力搜索数千篇论文了。

这也是官方所谓的“验证的不对称性asymmetry of verification”:验证容易,解答困难。但是,这就恰恰符合了这个测试的目标:大模型的检索能力。

虽不算完美,却也有效。它不是考验模型next token predidtion的能力,毕竟题干和答案都很短,也不太考验推理能力,因为不太需要什么深度研究分析(不过普遍来说推理模型的表现还是会更好),只要找得到信息,就能回答正确。

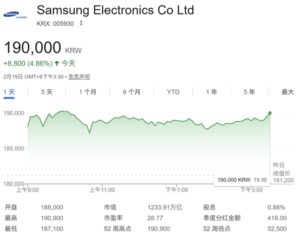

下图显示了BrowseComp的整体测试结果:花的时间越久,正确率越高,这也是之前DeepSeek会花那么久的原因之一,但是,正确率最高的模型,也就50%左右,而且严格来说,它还不算一个模型,而是agent。

浏览竞赛里的问题,实在也不好编,官方说,现在拢共只有1266个问题。官网放出了5道例题,我分别让DeepSeek V3、R1不开联网、R1开联网,分别测试了5个问题,每次都新开对话窗口,一共15次测试,全军覆没。(注意,这并非说DeepSeek在整个问题集里一道都做不对,而是正确率大概率很低)

而且,在没有联网的情况下,出现了前述的超长回答时间的问题,理论上,这种自我榨干的情况不该出现,它应该早一点发现自己其实根本无法作答,然后再给出一个它认为最有可能正确的猜测即可(注:R1的表现比V3好)。

那么,到底什么模型表现最好呢?很遗憾,OpenAI还只测试了自家的模型,暂时没啥横向可比性,虽然我认为浏览网页和寻找信息的能力,肯定是agent们包含的各种tool use能力里最重要的一个。

新上线的o3,不提它在视觉理解方面的能力,就因为相比o1有了browsing功能(当然还有更强的推理能力),正确率提高了很多。(o1在没有联网功能的情况下,仅靠内部知识库,答对了其中10%的问题)

我的三个小心得:

1、无论现有大模型在browsing方面表现如何,它们都在飞快进步和提升。

2、一旦遇到这种要查很多资料的任务,先让大模型做一遍,做对最好,没做对也没关系,它的搜索过程和给出的回答,还是能给你节约不少时间。

3、不要只问一次,在看了它第一遍的回答后,自己找找资料,思考思考,再继续给更多提示词,问第二次,第三次,榨干它,很快,你也会接近答错了。

本文来自微信公众号:一个胖子的世界,作者:柳胖胖