当Jensen遇到ASIC:从“ASIC白送也没人要”到“欢迎加入NVLink 家族”

【来源:虎嗅网】

本文来自微信公众号:共识粉碎机 (ID:botaijin),作者:Andy Liu

过去十年,AI算力大战像是一次“硬件加速版”的《速度与激情》:上一秒GPU仍在领跑,下一秒就有ASIC、TPU、NPU等各种“改装赛车”呼啸而来。我们从去年下半年开始讨论ASIC,今年初讨论PD分离和MoE架构对于NV的影响,很早就关注到了模型技术演进对于底层算力的变化需求。

Computex 2025见证了最戏剧化的一幕——向来将ASIC视作“旁门左道、白送也没人要”的Jensen Huang,突然在台北舞台上抛出NVLink Fusion,正式邀请第三方ASIC接入Nvidia的“AI工厂”管线。这一举动不仅改写了Nvidia对ASIC的叙事,也宣告了AI ASIC时代已不可逆转,尤其在推理(inference decoding)场景中更显锋芒。当然,Nvidia GPU一定还是算力不可或缺的主力之一,只是相比之下,ASIC有着更大的增量空间。

1. 老黄早年立场:GPU才是“未来保险”,ASIC注定“还在路上”

-

2017 年 TPU 冲击:Google在学术论文中声称 TPU 推理速度可比 K80 快 15–30 倍,引来 Nvidia 一次罕见的官方回应。Huang 强调“深度学习算法变化太快,把它们硬写进 ASIC 风险极高,GPU 的可编程性才是真正的护城河”;Nvidia的首席科学家Bill Dally也公开表示,TPU的算力优势可能本质上是来自于量化而非架构创新,GPU的架构通用性是非常强的壁垒,尤其涉及到复杂的指令集操作。

-

核心论点:算法狂飙+迭代周期=ASIC 可能“刚量产就落伍”,而 GPU 每一代仍向后兼容 CUDA。

趣味对比:那时的GPU在Huang口中是“瑞士军刀”,而ASIC只是“一把钉子锤”——钉子换了就得重新造锤子。

2. 中段过渡(2022–2024):警惕但自信,软件生态、互联+计算一体化成为新护城河

-

随着 AWS Inferentia、Tranium、Google TPU v5、Tesla Dojo 等 ASIC 落地,Huang 换了说法:“多数 ASIC 项目无法在我们的下一代 GPU 发布后仍保持优势,因为整套软件栈太复杂,不是谁都能重来一遍。”(Q4 FY2025 业绩电话会纪要)

-

论调升级:不再单谈 FLOPS,而是把 CUDA、TensorRT、NCCL、NVLink这些“系统级胶水”抬到护城河高度——“就算你做了 ASIC,也要先把整座软件山搬过去”,“GB200的推理TCO有30倍降低,未来每代都会数量级降低TCO,ASIC没有优势”。

3. Computex 2025:官方“投诚”——NVLink Fusion向第三方ASIC敞开大门

在台北音乐中心的90分钟独角戏里,Huang抛出了NVLink Fusion:

-

提供chiplet PHY+IP,允许Alchip、Marvell、MediaTek等在自家ASIC里直接挂上NVLink,总线带宽与Blackwell GPU等价。

-

同时宣布Grace-Blackwell架构支持异构任务调度,第三方芯片也能由CUDA/Nimble驱动。

话语体系彻底翻篇:“NVLink Fusion 让你可以把任何加速器接进我们的 AI 工厂。” ——Huang 现场致辞

信号:Nvidia 不再把 ASIC 视为“外来威胁”,而是系统租户;你可以带着自己那把菜刀进厨房,但炉灶、抽油烟机和菜谱依旧写着 NVIDIA。

4. 为什么偏偏是Inference Decoding先被ASIC颠覆?

-

算型稳定:生成式模型推理阶段主要是 GEMM + token softmax,算子稳定、精度可容忍INT8/FP8,适合硬化。

-

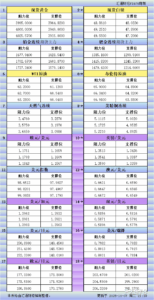

PD分离:随着集群式推理成为了主流,Inference未来的方向是PD分离(prefill和decoding分离),prefill是compute bound,而decoding是memory bound。Decoding天然对于通用性的要求低,而对于算法-芯片共同优化要求高,这给了ASIC非常大的空间。

-

部署规模:在2023-2024,大部分的算力都是用来做training。然后,随着2025年,agent元年的到来,inference的算力会逐渐变成大部分,未来inference的算力需求是巨大的。这么大的量,用自研ASIC来替代,是完全算的过来账的。

5. Nvidia的两手策略:GPU继续开路,ASIC交过路费

-

硬件层:把NVLink-Spine 当作 高速公路,第三方 ASIC 必须买“高速卡”才能上路;带动Switch & Fabric 收入。

-

软件层:推CUDA-Graph + TensorRT-LLM作“统一调度内核”,不管你是 GPU 还是 ASIC,都得用 Nvidia runtime。

-

商业层:与其阻击,不如“抽成”。NVLink Fusion ≈ Arm IP 授权模式 + AWS Nitro 思路。

6. 结语:从鄙视到拥抱,ASIC趋势已成大势

-

2017:“算法还在变,别急着做 ASIC。”

-

2025:“算法固化的那部分,欢迎接 NVLink 来跑。”

-

下一幕:推理侧能效神教与训练侧 规模神教并存GPU 做万能引擎ASIC 做高效涡轮,共同构成 AI 工厂流水线。

GPU仍是瑞士军刀,但在这个“Token工厂”时代,每把菜刀也在自成流派。

Jensen Huang想做的,是把整个厨房的排烟管都换成了NVLink。

当然这套NVLink Fusion好不好推,会持续跟踪,难度也很大。